如何开发能扛住百万用户的体育赛事直播平台架构

2025年05月06日

为什么同样一场比赛,有的平台能流畅支持百万用户,有的却在几万人同时在线时就崩溃?为什么弹幕系统总是最先崩溃的模块?为什么用户量激增时整个系统会像多米诺骨牌一样连锁崩溃?这些现象背后,隐藏着怎样的技术挑战?

拆解系统压力的来源,我们发现了5个“致命点”

架构单点:某个服务宕机,牵一发而动全身,无法快速恢复。

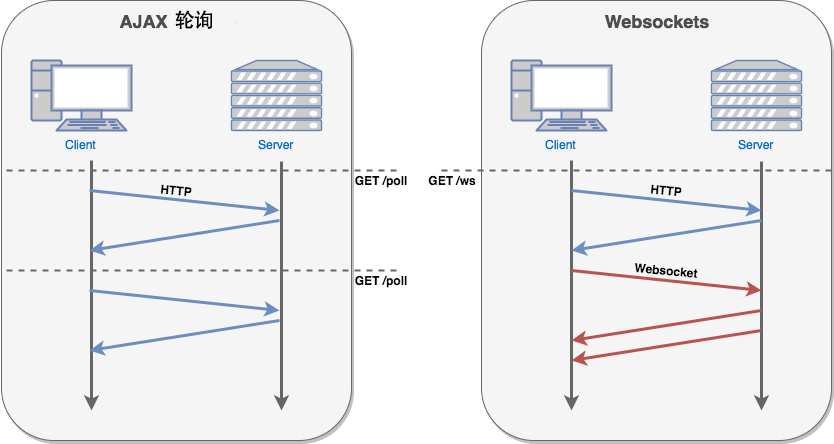

WebSocket失控:千万连接涌入,如果没有合理调度,会让服务端瞬间崩溃。

数据库瓶颈:弹幕、评论、点赞全都直写数据库,高并发下瞬间“堵死”。

带宽/CDN不足:视频分发跟不上用户增速,出现“加载转圈”。

没有降级机制:哪怕一个小服务挂了,也可能拖垮整个直播业务。

“东莞梦幻网络科技”实战方案,如何搭出能扛百万人的直播系统?

作为一套支持百万并发的体育赛事直播系统,东莞梦幻网络科技开发设计了一套稳定、高可用的体育直播系统源码架构:

1. 前端接入层优化

所有视频流和静态资源通过多地域CDN分发,保证全国访问不延迟

WebSocket 接入采用 OpenResty + Lua脚本,轻松应对百万长连接

2. 微服务拆分 + 服务网格

聊天、用户、弹幕、积分、推流等功能全部拆分部署

使用 gRPC + Nacos 进行服务注册与发现,效率更高、故障影响更小

3. 弹幕系统异步解耦

弹幕消息通过 Kafka 队列中转,不直接入库,避免数据库写爆

热门弹幕内容使用 Redis 缓存,读取更快不卡顿

4. WebSocket连接统一管理

利用 Redis + 心跳机制 管理连接状态,自动踢出僵尸用户

消息下发采用 Redis Pub/Sub,实现精准、实时推送

5. 数据存储优化

采用 MySQL 主从+分库分表,支撑高并发写入

热数据写入 Redis缓存层,后端异步入库,提升响应速度

6. 视频推流/拉流优化

支持 RTMP/SRT/HLS 多种推流协议,兼容性强

拉流部分交给 CDN+多码率自适应,弱网环境下也能流畅播放

7. 降级与容灾机制

弹幕挂了直播照播,服务降级不影响主业务

多机房部署 + 熔断机制,保证服务始终在线

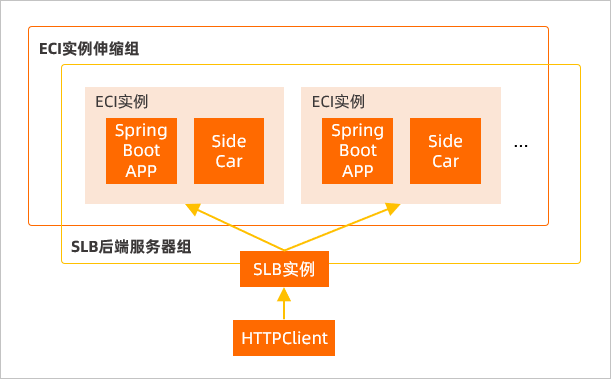

8. 实时监控 + 自动扩容

使用 Prometheus + Grafana 实时监控各节点负载

接入 阿里云/腾讯云弹性扩容,人多自动拉高资源,不怕突发流量

真正能“抗住百万人”的平台,从来不是靠堆机器,而是靠科学架构

体育直播不是靠堆带宽、拼服务器就能解决的,而是要有一套从架构设计到运维策略全链路支撑的技术体系。只有做好服务解耦、连接管理、弹性扩容、数据异步化,才能确保在高并发、高流量、高互动的环境下依旧“丝滑运行”。

你的平台还在卡?是时候重新审视你的架构了!